Visually-rich Document Information Extraction

Project 4: International Transport Form Extraction Method Using Multi-modal Pre-Training Models

研究背景

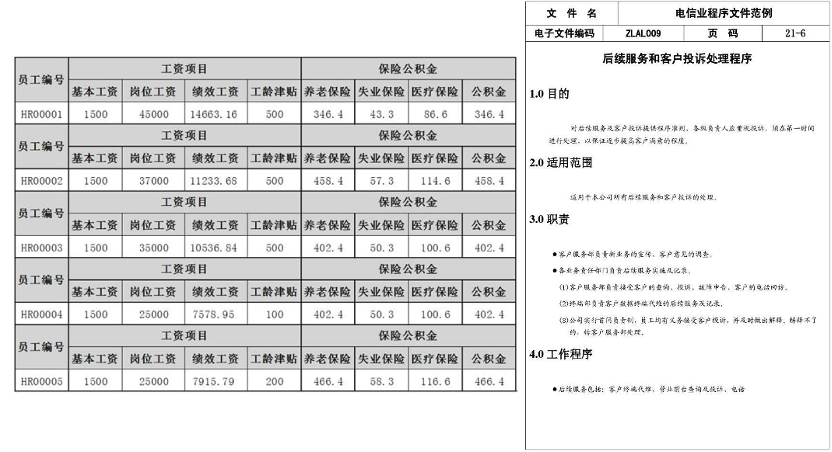

现如今,各行各业在商业业务运营中仍存在较多简单、重复、低级的劳动密集型的商业文档处理任务,如表格入库、发票整理、财务合规等等,不仅造成了大量人力资源的浪费,效率和准确性也存在一定瓶颈。提升现有商业文档的智能化和自动化处理水平,对促进人工智能时代的新型商业社会发展具有重要的商业价值和现实意义。

研究内容

1. 面向视觉富文档的多模态融合预训练增强表示技术

在当前数据驱动的时代下,随着新一代人工智能技术的不断发展,让计算机代替人工自动从非结构化商业文件中准确提取所需内容和内容间的关系成为了可能。机器人过程自动化工具(RPA)在商业文档的智能处理和自动化处理上起到了重要的作用。然而,现有的RPA技术往往是基于传统的光学字符识别(OCR)模型,难以解决富文本和图像文档的处理。为此,利用计算机视觉和自然语言处理等多方面技术,涉及文本阅读理解、图像识别和知识图谱等许多学科,开发文档智能化处理变得非常具有挑战性。在过去,早期的文档智能化处理方法通常集中于检测和分析文档的某些部分,比如表格区域,然而这些方法都有一些限制。最近微软亚洲研究院提出了一种新型的融合文本和布局的预训练模型LayoutLM,该模型可以精确地从不同类型的文档中提取出感兴趣的重要内容,通过文本、图像和布局位置信息的联合建模来进行智能文档理解,大大推进了文档AI领域的发展,并为文档AI相关项目指明了科学的研究方向,拓展了相关领域抽取模型的应用范围和提高了应用的精度和效率。

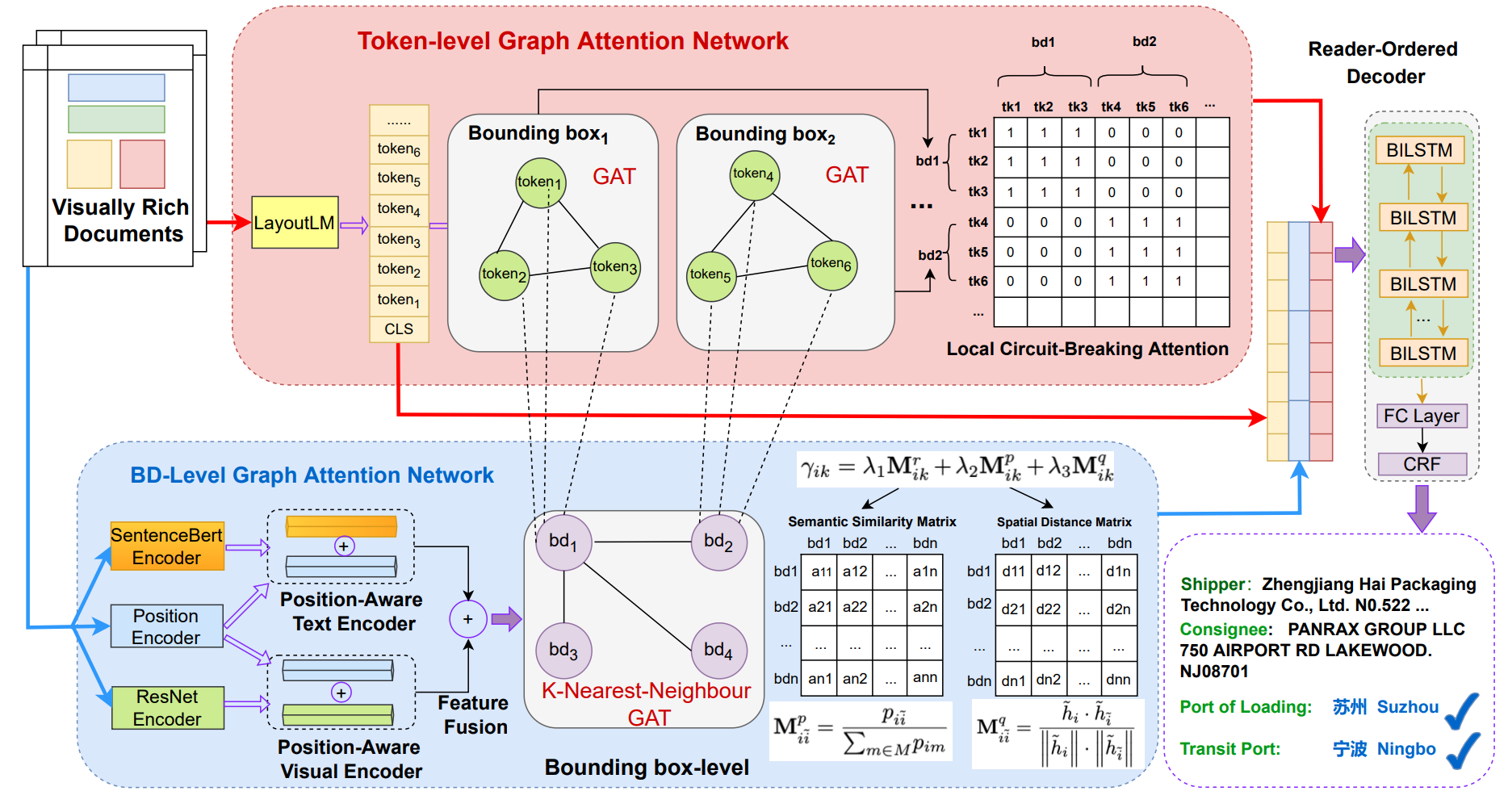

2. 基于多粒度精细关联的视觉富文档信息提取技术

视觉信息提取(VIE)是一项从单据图像中提取关键信息(如运单和收据)的任务。现有方法通常结合多模态信息,包括文本、视觉、布局特征,在各个领域的数据集上取得良好的结果。然而,以前的方法将VIE任务视为令牌级序列标注问题,没有明确建模边界框之间的关系。VIE任务严重依赖于上下文,尤其是键-值对之间的关系。为解决这个问题,在本文中,我们提出了一个双级图注意模型,结合粗粒度和细粒度信息。在细粒度令牌级别上,我们要求图注意网络集中注意力于其边界框内的本地领域的令牌邻居上。在粗粒度边界框级别上,我们鼓励进一步的边界框之间的信息交互,并更加关注潜在的键值对。据我们所知,我们的方法可能是首次尝试在一个统一的微调框架下联合建模边界框和标记之间的相关性。实验结果表明,所提出的方法显著超过了以前的方法。与强劲的基线布局LM相比,我们的方法在两个数据集上的F1分数提高了约3%,该方法是现有VIE方法的重要补充。

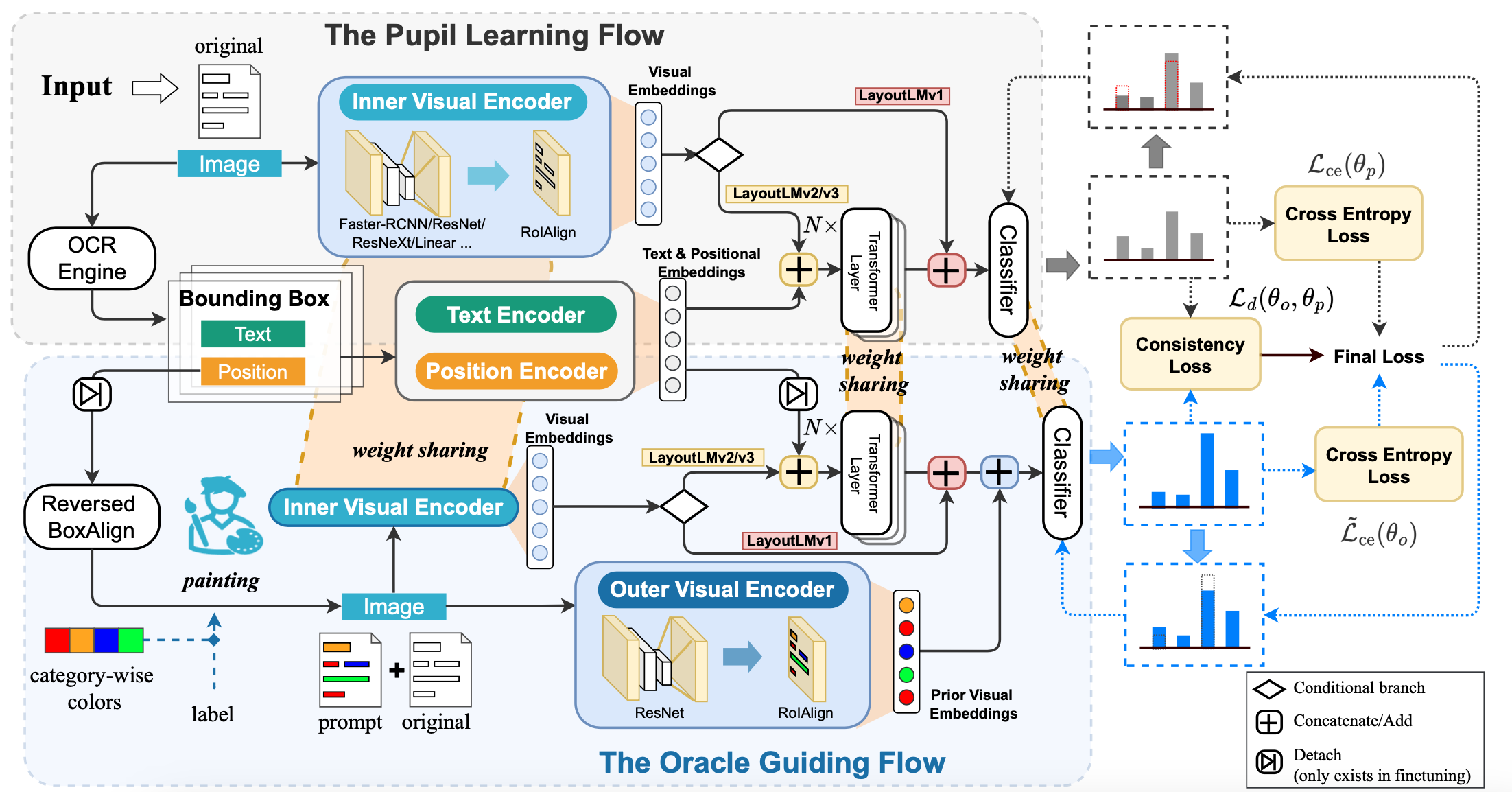

3. 基于视觉不对称学习的视觉富文档信息提取技术

表格文档信息提取是一个旨在从视觉丰富的表格文档中提取预定义类别的有意义实体的任务。与针对平面文本的经典信息提取任务相比,对于表格文档,自然而然地利用更多的视觉线索,因为属于相同类别的语义实体通常以类似的字体、背景、颜色和边界框长度呈现。尽管边界框级别的视觉信息非常重要,但大多数现有方法忽略了这种先验知识。为解决这个问题,我们提出了一种新颖的视觉异形一致性学习方法,巧妙地利用丰富的提示颜色涂料,将边界框级别的视觉信息的先验知识融入到学习中。我们的方法有效地减轻了视觉和文本模态之间的不一致性,从而促进了无偏的多模态表示学习。实验结果表明,我们的方法在两个小型基准数据集和一个独立于所使用的骨干网络的大型真实世界数据集上显著优于强大的LayoutLM基线。除此之外,我们还进一步研究了涂料中颜色方案与模型性能之间的相关性。