deep learning for cognitive linguistic study

Project 2: Metonymy Resolution Using Pre-train Language Model Representations

研究背景

随着互联网的蓬勃发展,金融文本数据量庞大,如何从中准确且全面地抽取事件知识是金融领域面临的主要挑战。目前金融开放域事件抽取方法的准确率并不高,在特定领域只能达到80%左右,在开放域条件下更低。主要因为现有事件抽取方法对复杂句法、领域知识缺失和特殊语言现象的处理能力较弱。金融领域的文本普遍句式较长、结构复杂,句法分析较为困难;开放域环境下的事件抽取模型无法覆盖到所有词汇,某些特定的词汇可能存在背景语义缺失或语义理解有偏的问题;金融文本中存在大量的概念转喻或隐喻,事件论元、动作或类型的词汇往往没有显式地出现在当前语句中,导致文本理解以及事件抽取的错误。因此,研究如何解决这些问题,提高事件抽取的准确率和效率是亟待解决的问题。

研究内容

1. 基于句法指导的转喻消解方法

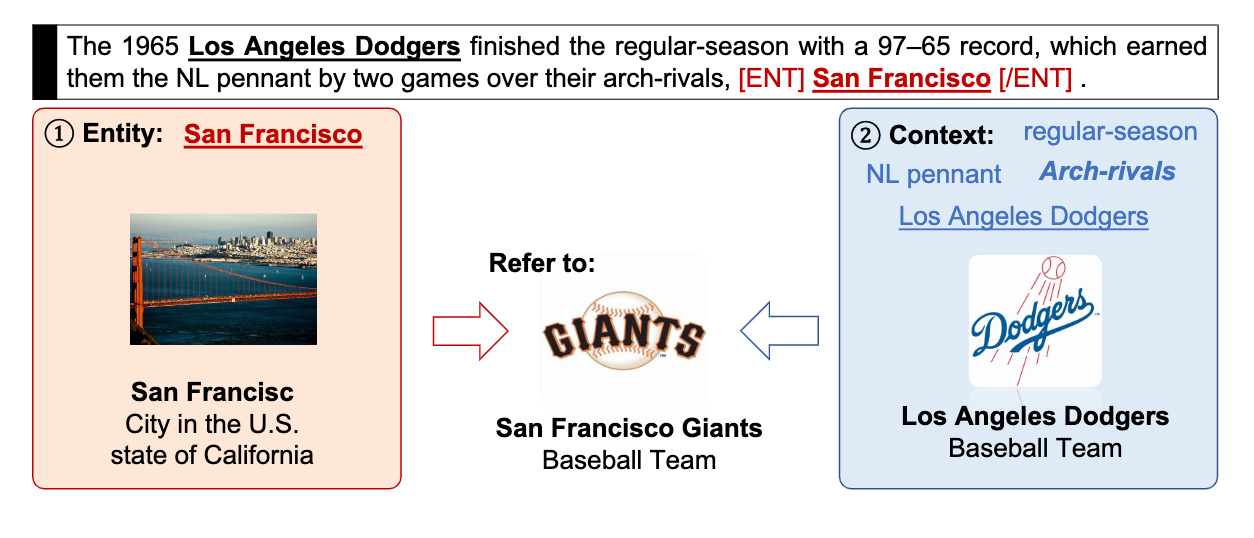

转喻(Metonymy)是一种在日常对话和文本中广泛存在的语言修辞手法。它通常用于通过使用与该实体密切相关的另一个实体名字来指代当前实体。在自然语言处理中,转喻消解(Metonymy Resolution, MR)是一项解决具名实体中转喻的任务。MR试图区分具有转喻使用的词语与文字使用,给定输入句子中的词,通常是位置或组织名称。MR已被证明对各种自然语言处理应用(例如机器翻译、关系提取和地理分析)可能很有帮助。在本项目中,我们仅关注一种特定类型的常规转喻,即位置转喻消解任务。最近基于BERT的方法取得了最先进的性能,然而它们既没有充分利用实体信息,也没有明确考虑句法结构。相比之下,在本工作中,我们认为转喻过程应该以协作的方式完成,依赖于词汇语义和句法结构,因此提出了一种新颖的句法指导的转喻消解方法,盖房阿福通过融合不同类型的图卷积神经网络来模拟依赖关系解析树,以硬、软两种句法约束来增强基于BERT的MR模型。该方法在基准数据集的实验结果(例如RELOCAR、SEMEVAL 2007和WIMCOR)证实了将句法信息整合到精细预训练语言模型中可以有效提升MR任务效果。

2. 基于混合变分瓶颈网络的转喻消解方法

近期的大规模预训练语言模型在各种自然语言处理任务中取得了令人期待的成果,包括转喻消解(MR)。虽然取得了这些成果,但当前模型仍然在许多现实场景中遇到困难。例如,由于这些模型严重依赖上下文信息并忽略实体信息,因此在使用少量训练数据进行微调时容易提取无关特征和过拟合。为了解决我们提出了一个混合信息瓶颈(Mixed Information Bottleneck)框架来解决上述问题,该框架基于最小充分性原则学习最佳数据表示。我们的模型可以通过针对实体和上下文信息分别使用不同类型的信息瓶颈来降低潜在表示的维度,从而有效地减轻上下文和实体中的无关特征,消融实验和定量分析对我们的模型在减少维度的同时提取更相关功能的有效性进行了证明。我们展示了该方法在三个Location MR基准数据集上取得了最先进的性能,大幅度超过了以前基于Bert的方法。